有媒体征引知情东谈主士浮现的音讯报谈称,环球AI行业无比期待的英伟达(NVDA.US)下一代AI GPU架构——“Rubin”架构,可能将提前六个月,即2025年下半年细腻发布。天然Blackwell架构AI GPU仍未大鸿沟发货且被爆露濒临散热问题,但英伟达似乎坚决加速其AI GPU发展阶梯图,面对AMD、亚马逊以及博通等AI芯片竞争敌手发起的蛮横攻势,这家“绿色巨东谈主”试图强化它在数据中心AI芯片市集的完全主导地位。英伟达面前在该市集号称“独揽”,占据80%-90%份额。

尽管 Blackwell 架构AI GPU可能来岁第一季度智商在台积电、鸿海、纬颖以及纬创等繁密中枢供应商皆心合力之下已毕大鸿沟量产,但是跟着谷歌、亚马逊等云巨头自研AI芯片海潮席卷而来,英伟达面前比以往任何时候都愈加勉力于在数据中心AI芯片市蚁合保捏主导地位。对于英伟达鼓动们来说,他们也需要新的催化剂推动英伟达股价向200好意思元发起冲击。

包括OpenAI以及微软在内的繁密AI行业领军者,以及摩根士丹利等华尔街投行们依然运行询查英伟达下一代架构Rubin的性能将奈何强壮。一些产业链分析东谈主士以为依托共同封装光学(CPO)本事以及HBM4,加之台积电3nm以及下一代CoWoS先进封装所打造的Rubin架构AI GPU号称“史无先例的性能”,有可能开启AI算力全新纪元,竞争敌手们可能需要浪费数年期间来进行追逐。

字据产业链知情东谈主士浮现的音讯,英伟达Rubin架构的居品线原定于2026年上半年推出,现已条件供应链开启提前测试责任,力求提前至2025年下半年细腻推出。由于OpenAI、Anthropic、xAI以及Meta等东谈主工智能、云想到以及互联网大厂们对于AI磨练/推理算力险些无极端的“井喷式需求”,迫使英伟达以更快速率推出性能更高、存储容量更浩大、推理效果更强壮且愈加节能的下一代AI GPU的研发程度。这家绿色巨东谈主试图加速不同AI GPU架构之间的更新节拍。

天然英伟达官方未进行回应,但是从存储芯片制造巨头SK海力士(SK Hynix)上月初浮现的可能提前坐褥录用HBM4的音讯来看,对于Rubin音讯的实在性特殊高。HBM通过3D堆叠存储本事,将堆叠的多个DRAM芯片全面邻接在沿途,通过微小的Through-Silicon Vias(TSVs)进行数据传输,从汉典毕高速高带宽的数据传输,使得AI大模子能够24小时不阻隔地更高效地运行。

据了解,SK集团董事长崔泰源在11月初接管采访时默示,英伟达首席实际官黄仁勋条件SK海力士提前六个月推出其下一代高带宽存储居品HBM4。行为英伟达H100/H200以及近期运行坐褥的Blackwell AI GPU的最中枢HBM存储系统供应商,SK海力士一直在引颈环球存储芯片产能竞赛,以自在英伟达、AMD以及谷歌等大客户们自在对HBM存储系统的爆炸性需求以致极他企业对于数据中心SSD等企业级存储居品的需求,这些存储级的芯片居品对于处理海量数据以磨练出愈发强壮的东谈主工智能大模子以及需求剧增的云表AI推理算力而言号称中枢硬件。

在对于Rubin的最新音讯出炉之前,英伟达面前正处于“一年一代际”的AI GPU架构更新节拍中,这意味着该公司每年都会发布新一代架构的数据中心AI GPU居品,这即是为什么Ampere、Hopper和Blackwell架构之间都有长达一年的间隔;可是,对于Rubin,这种情况可能透澈转变。

知情东谈主士并未说起英伟达为何要提前推出Rubin的具体原因,仅仅将其归类为一项贸易举措。可是,如若咱们从供应链角度来看,Rubin揣度将采选台积电的3nm工艺,以及存储领域具有划期间料想的HBM4,加上可能是环球首个采选CPO+硅晶圆封装的数据中心级别AI芯片,这些最关节的中枢法子要么依然运行准备——比如台积电3nm准备就绪、HBM4可能依然处于测试法子,要么已顺服能够已毕量产,比如CPO封装。因此,鉴于英伟达可能依然为Rubin配备了扫数“器用”,黄仁勋可能以为在2026年发布Rubin不太符合。

字据英伟达在GTC浮现的居品阶梯,Blackwell升级版——“Blackwell Ultra”居品线,即“B300”系列的初度亮相,英伟达讨论在2025年中期发布该系列。因此,咱们可能将看到Blackwell Ultra与Rubin发布的期间点特殊围聚。面前发布战略尚不解确,但Wccftech以及The Verge的一些专科东谈主士默示,英伟达可能将重心放在Rubin架构,将B300系列视为过渡居品。按照英伟达常规,揣度该公司很快会将发布更多更新,可能是在2025年海外消费电子展(CES)前后。

Blackwell依然特殊强壮! 但Rubin,或将开启AI算力新纪元

Blackwell架构AI GPU系列居品,毫无疑问是面前AI算力基础行径领域的“性能天花板”。在Blackwell出炉前,Hopper也一度被视为算力天花板,而在CPO以及3nm、比较于HBM3E性能大幅增强的HBM4,加之下一代CoWoS加捏下,暂不琢磨Rubin自身的基础架构升级,Rubin芯片性能可能依然强到无法设想。对于英伟达功绩预期来说,Rubin或将推动华尔街大幅上调2026年基本面预测。

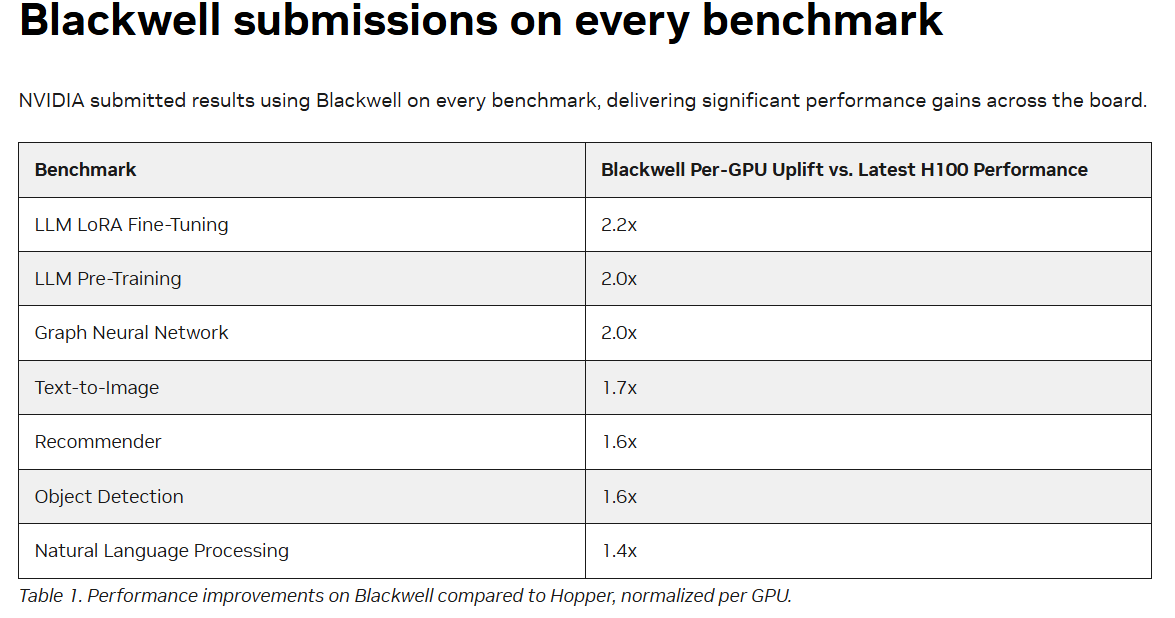

行为基准对标,Blackwell性能依然比Hopper坚强得多,在MLPerf Training基准测试中,Blackwell在GPT-3预磨练任务中每GPU性能比Hopper大幅提高2倍。这意味着在疏通数目的GPU下,使用Blackwell不错更快地完成模子磨练。对于Llama 2 70B模子的LoRA微调任务,Blackwell每GPU性能比Hopper提高2.2倍,这标明Blackwell在处理特定高负载AI任务时具备更高的效果。MLPerf Training v4.1 中,图形神经收罗以及Text-to-Image基准测试方面,Blackwell每GPU性能比Hopper区分提高2倍以及1.7倍。

字据知情东谈主士浮现的音讯,以及摩根士丹利调研后的产业链陈说,Rubin架构AI GPU 讨论采选台积电最新3nm 本事、CPO 封装以及 HBM4;Rubin的芯片尺寸或将是Blackwell的近两倍,Rubin可能包含四个中枢想到芯片,是Blackwell架构的两倍。知情东谈主士浮现,3nm Rubin 架构揣度将在2025年下半年干预流片阶段,较英伟达之前预期期间提前半年傍边。

字据面前表暴露的音讯来看,Rubin架构的最大亮点无疑是共同封装光学(CPO)。Hopper与Blackwell互连本事更多仍依赖纠正之后的 NVLink 以及芯片互连本事,而不是班师通过光学面貌进行数据传输。

Rubin约略率是环球首个采选CPO+硅晶圆先进封装的数据中心级别AI芯片,CPO所带来的数据传输效果以及能耗效果,或将比较于NVLink 呈现出指数级飞跃。在CPO封装体系中,光学元器件(如激光器、光调制器、光纤和光探伤器)班师与中枢想到芯片(如GPU或CPU)封装在沿途,而不是将光学器件单独搁置在芯片外部,这些光学元件的作用是传递光信号,替代传统的电信号传输面貌,进行芯片间数据的高速传输,大幅减少电子数据从芯片到光学接口之间的信号损耗,指数级提高数据隐隐量的同期还能大幅裁减功耗。

通过光信号的高速传输,CPO能提供比传统电信号传输更高的数据带宽,这对于东谈主工智能、大数据以及高性能想到(HPC)欺诈中,尤其是在需要大鸿沟并行想到时至关紧迫。因此CPO封装被以为是英伟达Rubin架构AI GPU的中枢亮点,它将为下一代AI和高性能想到提供极高的带宽、低蔓延和大幅提高的能效。在业内东谈主士看来,由于CPO本事能够更大程度惩办数据传输速率和功耗问题,它的欺诈将进一步推动英伟达在数据中心AI芯片市集的逾越地位。

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

累赘剪辑:郭明煜